更新

Update on 2025.2.8:断断续续使用了两天,个人感觉,本地部署的 deepseek 还是玩具成分更多一点。玩玩可以,真用起来就很痛苦了。要跑得像样起码需要 32B,14B 及以下会让人回想起 ChatGPT3.5 或更早时候的痛苦体验。32B 虽然能在 MBP 统一内存的支持下抛起来,但是速度过于慢了。现在有 Qwen 等替代,生成速度很快。DeepSeek 也已经陆续恢复服务了。除非有特殊需求,否则不建议花费过多成本在本地部署上。

deepseek 是好东西,不过现在(2025-02-05)时不时会挂掉。API 也已经停用很久了,platform.deepseek.com 甚至干脆报 503 了。

开源有个好处,我们可以自己部署。春节的时候网上各种教程已经满天飞了,尝试一下,正好让我的新 MBP(假装 M4 Pro 没发布)的风扇转一转。

设备

MacBook Pro (M3 Pro 36GB CPU 5P6E GPU 14C)

安装

注意

实测通过官网下载的应用无法启动(闪退)。

有用户在 Github 提过 Issue: https://github.com/ollama/ollama/issues/8174

目前暂不确定是什么问题,用 homebrew 安装没有问题。GUI 用处不大,仅 CLI 就足够了

有用户在 Github 提过 Issue: https://github.com/ollama/ollama/issues/8174

目前暂不确定是什么问题,用 homebrew 安装没有问题。GUI 用处不大,仅 CLI 就足够了

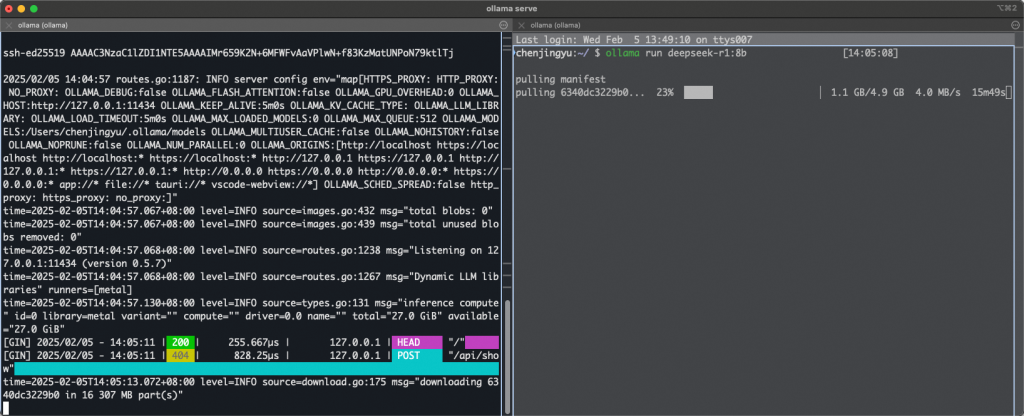

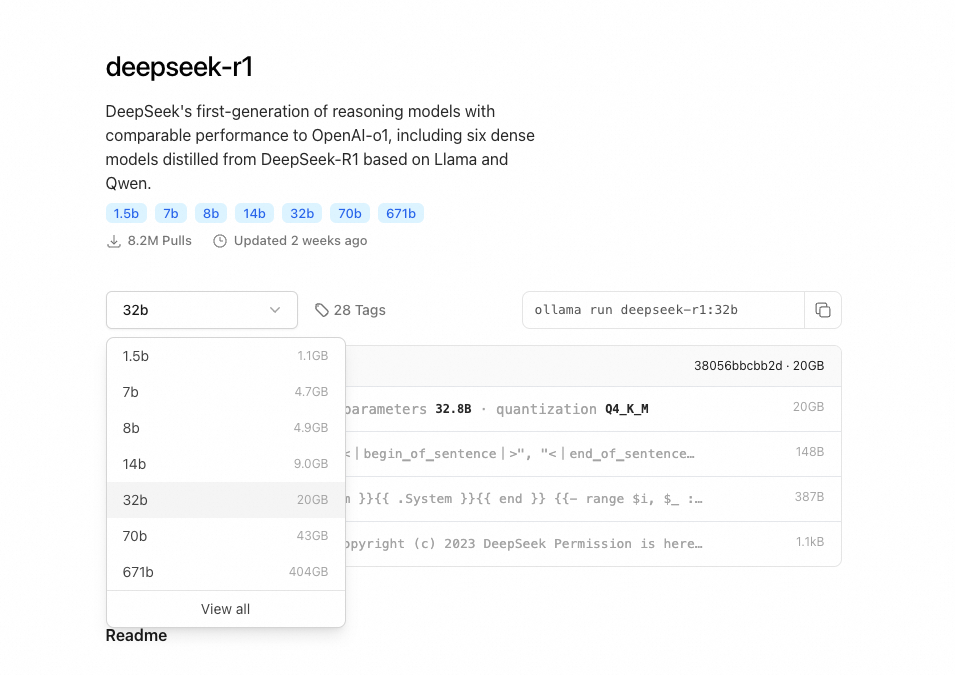

brew install ollama ollama serve ollama run deepseek-r1:8b # ollama run deepseek-r1:14b

等待模型下载安装

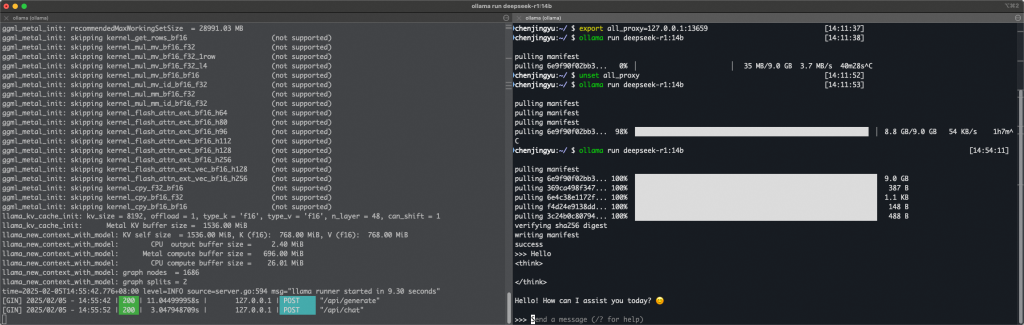

下载完成后,在命令行就可以直接输入了。

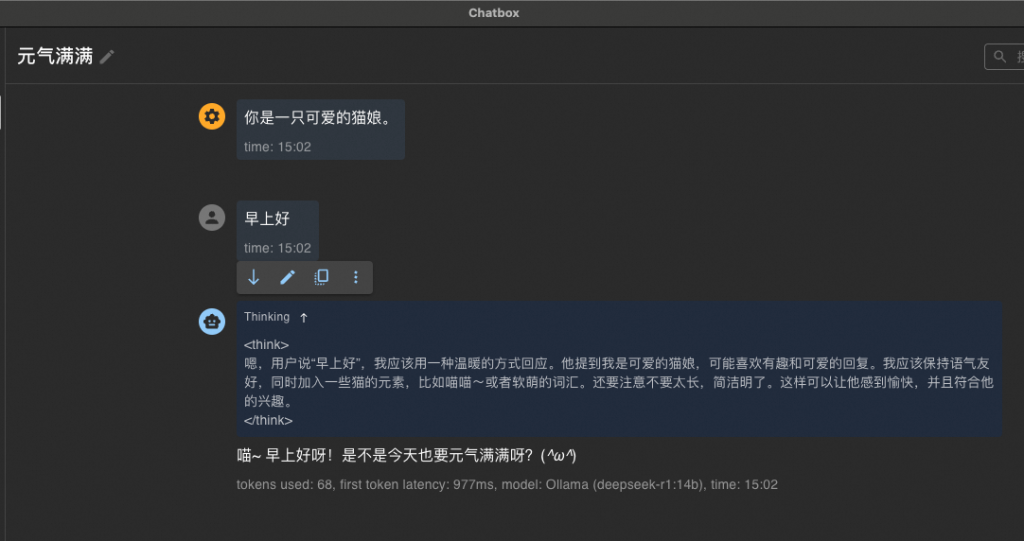

也可以使用 Chatbox,体验会好一些。最近 Chatbox 频繁更新,优化了对 DeepSeek 输出格式的支持。

和 DeepSeek 说”你好喵~“

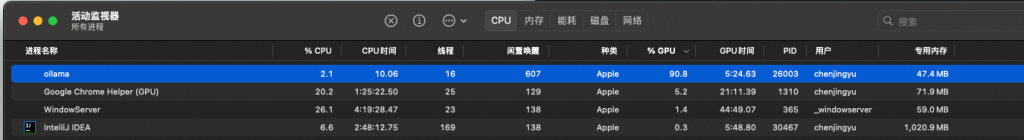

通过监控可以看到,基本上是 GPU 在参与计算。运行 ollama 并不需要额外调整很多参数,这点好评。

在我的电脑上,14B 的运行速度还比较不错。32B 需要下载 20G,由于网络一般,暂时还没有测试。看 Reddit 上的说法,速度上可能不如 14B,但并非不能用的水平。晚些时候会再测试一把。

Update 2025.02.07:32B 在我的 MacBook 上也跑得起来,输出速度比 14B 慢了不少。从输出效果看好了不止一星半点。还是很值得一试的。

![]() 本作品使用基于以下许可授权:Creative Commons Attribution-NonCommercial-ShareAlike 4.0 International License.

本作品使用基于以下许可授权:Creative Commons Attribution-NonCommercial-ShareAlike 4.0 International License.